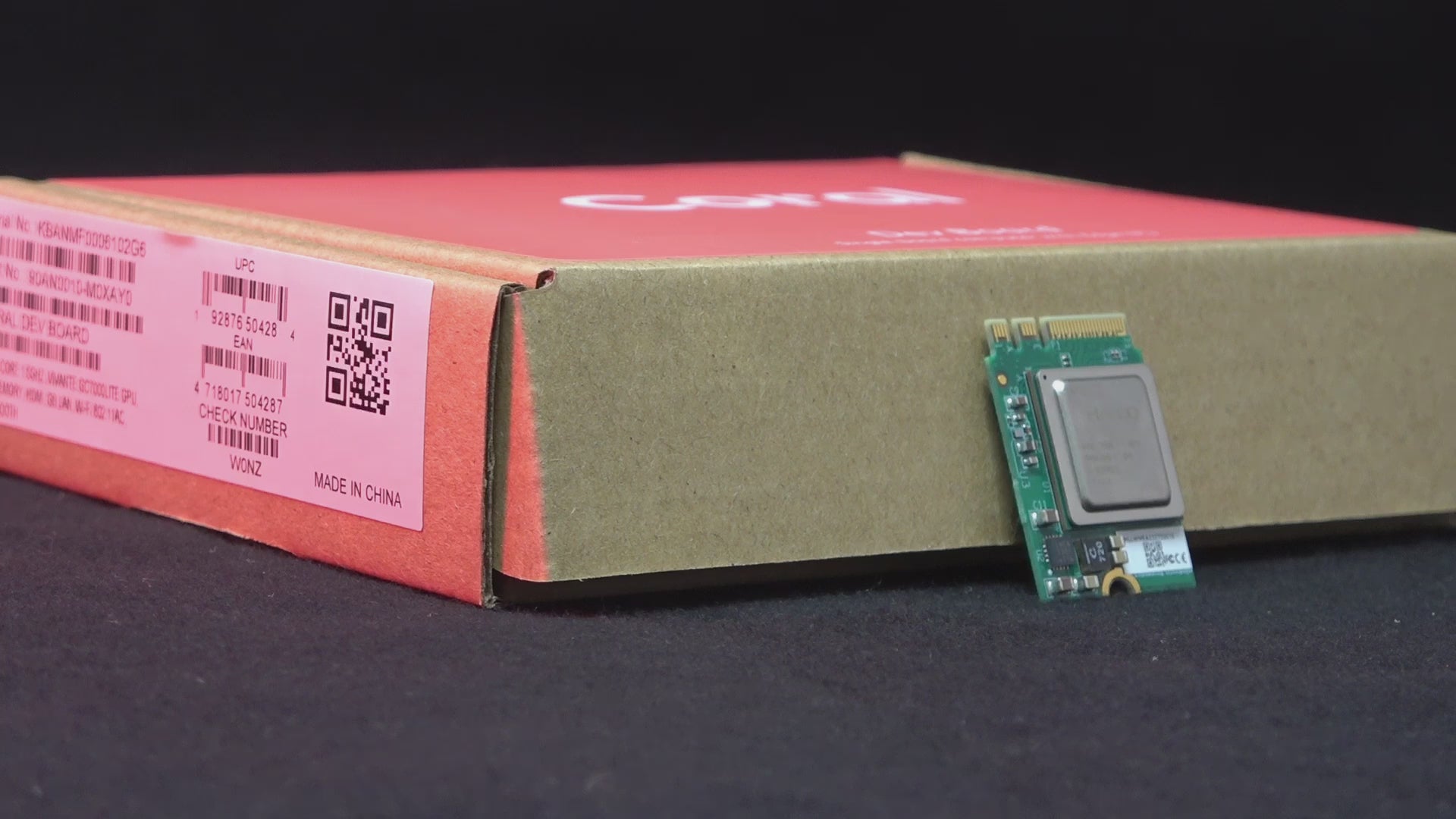

Hailo-8 ist ein moderner KI-Beschleunigerchip für Deep Neural Networks. Hailo-8 ist insbesondere für Vision-Anwendungen geeignet. Das ist die M.2 A+E-key 2230 Variante des Hailo-8 AI Processors. Zum Betrieb wird eine Host-CPU benötigt.

Technische Daten

HAILO-8 AI Accelerator

- bis zu 26 TOPS INT8 performance (trillion operations per second = 26 Billionen Rechenoperationen pro Sekunde / 2,6 * 10^13 Rechenoperationen)

- Formfaktor: M.2 2230 A+E-Key

- Abmessungen: 22×30 mm

- Interface: PCIe Gen-3.0, 2 Lanes (bis zu 16 Gbs)

-

TDP: 6.93 W

Softwareunterstützung (Inferencing)

- führt Deep Learning Neural Networks mit hoher Leistungseffizienz aus

- besonders gut für CNNs geeignet (Computer Vision Anwendungen)

- ermöglicht parallel mehrere Modelle & Streams zu prozessieren

- Linux, Windows

- Unterstützt TensorFlow, TensorFlow Lite, Keras, PyTorch, ONNX

- Kompatibel mit ARM und x86 Systemen.

Hinweise

- CE & FCC Class A zertifiziert

- Betriebstemperatur: -40°C - +85°C (Umgebungstemperatur) für die HM218B1C2KAE Variante (industrieller Temperaturbereich)

- Optional auch als Hailo-8 starter Kit erhältlich

(siehe HAILO Website als Grafikquelle mit Erklärung der Testparameter)

Für den Betrieb muss sichergestellt werden, dass die Hitze die das Hailo-8 Modul erzeugt abgeführt wird. Das Modul wurde so designed dass die meiste Hitze zur metallischen Abdeckung des Chips (Top Surface of the Package) hin abgeleitet wird. Wir empfehlen die Application Note "Hailo-8 AI Acceleration Module Thermal Design Considerations" zu lesen.

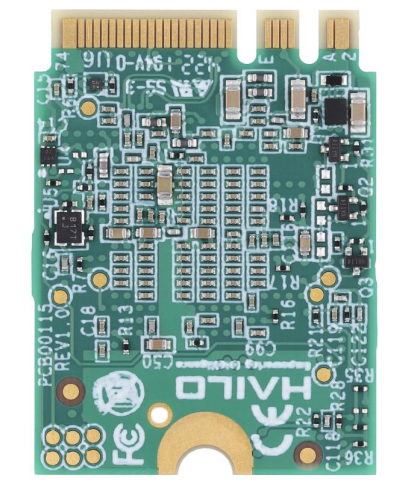

- es gibt zwei Varianten des Moduls. Abgebildet ist die MEA Konfiguration. Eine weitere, funktionell und leistungsmäßig identische MEB Konfiguration existiert, aufgrund von einer alternativen Auslegung der Stromversorgungskomponenten.

Dokumentation & Downloads

- HAILO-8 M.2 AI Acceleration Modules Product brief (PDF)

- Hailo Developer Zone

- Hailo Software Downloads - alles was benötigt wird um Hailo AI Prozessoren zu installieren und zu betreiben

- Hailo Dokumentation und Datenblätter

- Hailo Model Explorer - ermöglicht das passendste AI Modell als Basis für Ihre Anwendung zu wählen

- Hailo Community

- Hailo auf GitHub

Beratung durch buyzero

Wir beraten Sie ob Ihr Modell auf dem HAILO-8 lauffähig ist, und ob Sie Ihr Projekt mit Hilfe von HAILO-8 umsetzen können. Kontaktieren Sie uns dazu bitte.

FAQ

Was sind Beispielanwendungen für dieses Modul?

Man kann mit diesem Modul sogenannte Deep Learning Algorithmen, insbesondere CNNs (convolutional neural networks), beschleunigen.

Dazu gehören:

- Pose Estimation - Schätzung der Pose eines Menschen

- Objekterkennung mit Bounding Boxes (bspw. wo ist ein Fahrrad im Bild, und was ist es)

- Segmentierung - markiere die Bereiche eines Bildes die eine Banane einnimmt

- Nummernschilderkennung

- Gesichtserkennung

- u.v.m.

Kann ich Modelle für den HAILO-8L auch auf einem HAILO-8 laufen lassen?

Ja, das ist möglich! Modelle die für den HAILO-8L kompiliert worden sind laufen auch auf einem HAILO-8.

Ich brauche eine höhere Durchsatzrate / Framerate

Das HAILO-8 M.2 M-key Modul hat eine Anbindung mit 4 PCIe Gen-3.0 Lanes, während das B+M Modul und das A+E Modul nur 2 Lanes nutzen können. Eine höhere Framerate könnte bspw. auch durch die Limitation durch die PCI Express Bandbreite beeinflusst sein - wir empfehlen daher als erstes die M-Key Variante auszuprobieren. Dabei sollte natürlich sichergestellt werden, dass der Host-Computer die vier PCIe Lanes bereitstellen kann. Falls die Framerate immer noch unbefriedigend ist, lesen Sie bitte die nächste Frage (Ich benötige mehr TOPS).

Ich benötige mehr TOPS, da ich eine komplexe Anwendung habe, was kann ich tun?

Dieses HAILO-8 Modul, hat 26 TOPS.

Wir bieten in unserem Shop auch eine Lösung mit 52 TOPS - das Biscotti Modul an. Es nutzt dazu zwei HAILO-8 Module, und hat einen EDSFF E1.S Anschluss - der in Storage Servern zum Einsatz kommt.

Dadurch kann das Biscotti Dual HAILO Modul auch in Clustern verbaut werden, und in einem 19'' Server bspw. auf 1600 TOPS skaliert werden. Wir stehen gerne bei Fragen zur Verfügung!

Ist der HAILO-8 eine gute Alternative zum Google Coral?

Ja, der HAILO-8 ist für Anwender mit höheren Leistungsansprüchen eine gute Alternative zur Google Coral Serie.

Google Coral kann hingegen gut in Anwendungen zum Einsatz kommen wo 4 TOPS Rechenleistung ausreichen, da sie günstiger sind.

Kann ich LLMs auf dem HAILO-8 ausführen, bpsw. LLAMA?

LLMs = Large Language Modelle (so etwas wie ChatGPT / GPT4-o, bzw. LLAMA, Falcon, usw.)

Nein, dafür ist der HAILO-8 nicht ausgelegt. Grafikkarten auf denen diese LLMs typischerweise laufen haben schnellen direkt angebundenen Speicher. Der HAILO-8 hat unter anderem nicht genügend Speicher, um diese Modelle laden zu können.

HAILO hat ein zukünftiges Produkt, den HAILO-10 angekündigt. Dieser wird eine Speicherschnittstelle haben, und auch GenAI Anwendungen wie LLMs besser unterstützen.

Kann ich damit Modelle trainieren?

Nein, der HAILO-8 ist ausschließlich für die Inferenz (int8) gedacht. Zum Training von Modellen wird typischerweise eine klassische GPU eingesetzt.

HAILO bietet hier Unterstützung mit einer Reihe von vorgebauten Docker-Containern, mit denen Modelle trainiert und auch angepasst werden können.

Das Model Build Environment wird wie im Diagramm gezeigt auf einem eigenen dafür vorgesehenen Computer betrieben, der über die notwendigen technischen Parameter verfügt. HAILO-8 selbst ist für Edge-Anwendungen gedacht, für die Inferenz, zusammen mit der HailoRT Runtime.

Wir unterstützen gerne bei technischen Fragen zu Modellen.

Physikalische Abmessungen

Alle Abmessungen in mm. Nur als Referenz, nicht für 3D-Modellierung geeignet.

Misc

- Hailo SKUs / alternative Bezeichnungen:

- HM218B1C2KAE = Hailo-8, M.2 module A+E key 2230 - industrial

Temp. -40 to +85°C - HM218B1C2KAE/HAI

- HM218B1C2KAE = Hailo-8, M.2 module A+E key 2230 - industrial

- HS Code: 85176200

- Country of origin: Taiwan

- Packungsmenge einer Großverpackung: 20 (auf dieser Seite bestellen Sie ein Stück, wenden Sie sich bei Großbedarf gerne an uns)

- Lead Time (Nachlieferzeit): aktuell 12 Wochen

English Description

Hailo-8 is a modern AI accelerator chip designed for deep neural networks, particularly suitable for vision applications. This is the M.2 A+E-key 2230 variant of the Hailo-8 AI Processor. A host CPU is required for operation.

Technical Specifications

- Model: HAILO-8 AI Accelerator

- Performance: Up to 26 TOPS INT8 (trillion operations per second = 26 billion operations per second / 2.6 × 10^13 operations)

- Form Factor: M.2 2230 A+E-Key

- Dimensions: 22×30 mm

- Interface: PCIe Gen-3.0, 2 lanes (up to 16 Gbps)

- TDP: 6.93 W

Software Support (Inferencing)

- Executes deep learning neural networks with high performance efficiency

- Particularly well-suited for CNNs (Computer Vision applications)

- Allows processing of multiple models & streams in parallel

- Supports Linux and Windows

- Compatible with TensorFlow, TensorFlow Lite, Keras, PyTorch, ONNX

- Compatible with ARM and x86 systems

Notes

- CE & FCC Class A certified

- Operating Temperature: -40°C to +85°C (ambient temperature) for the HM218B1C2KAE variant (industrial temperature range)

- Also available as Hailo-8 starter kit

For operation, ensure that the heat generated by the Hailo-8 module is dissipated. The module is designed to direct most heat towards the chip's metal cover (Top Surface of the Package). We recommend reading the application note "Hailo-8 AI Acceleration Module Thermal Design Considerations."

There are two variants of the module. The MEA configuration is shown, and there is another functionally and performance-wise identical MEB configuration due to an alternative design of the power supply components.

Consulting through buyzero

We will assess whether your model can run on the HAILO-8 and if you can implement your project with the help of HAILO-8. Please contact us for assistance.

FAQ

What are example applications for this module?

This module can accelerate deep learning algorithms, particularly CNNs (convolutional neural networks). Examples include:

- Pose estimation

- Object detection with bounding boxes (e.g., identifying bicycles in images)

- Segmentation (marking areas of an image occupied by a banana)

- License plate recognition

- Face recognition

- And more.

Can I run models compiled for HAILO-8L on a HAILO-8?

Yes, models compiled for the HAILO-8L will run on a HAILO-8.

I need a higher throughput/frame rate.

The HAILO-8 M.2 M-key module has a connection with 4 PCIe Gen-3.0 lanes, while the B+M module and the A+E module can only use 2 lanes. A higher frame rate may also be influenced by the limitation of PCI Express bandwidth; we recommend trying the M-Key variant first, ensuring that the host computer can provide the four PCIe lanes. If the frame rate is still unsatisfactory, please refer to the next question (I need more TOPS).

I need more TOPS for a complex application; what can I do?

This HAILO-8 module has 26 TOPS. We also offer a solution with 52 TOPS, the Biscotti module, which utilizes two HAILO-8 modules and has an EDSFF E1.S connector for use in storage servers. This allows the Biscotti dual HAILO module to be used in clusters, scaling up to 1600 TOPS in a 19” server. We are happy to assist with any questions!

Is the HAILO-8 a good alternative to Google Coral?

Yes, the HAILO-8 is a good alternative for users with higher performance requirements compared to the Google Coral series. Google Coral is better suited for applications where 4 TOPS of computing power are sufficient due to its lower cost.

Can I run LLMs on the HAILO-8, e.g., LLAMA?

No, the HAILO-8 is not designed for that. GPUs typically used for LLMs have fast, directly attached memory. The HAILO-8 does not have sufficient memory to load these models. HAILO has announced a future product, the HAILO-10, which will feature a memory interface and better support for GenAI applications like LLMs.

Can I train models with it?

No, the HAILO-8 is exclusively for inference (int8). Traditional GPUs are typically used for training models. HAILO offers support with a range of pre-built Docker containers for model training and adaptation.

The Model Build Environment will be operated on a dedicated computer that meets the necessary technical parameters, as shown in the diagram. HAILO-8 itself is designed for edge applications, for inference, along with the HailoRT Runtime.

We are happy to assist with any technical questions about models.

Miscellaneous

Hailo SKUs / alternative designations:

- HM218B1C2KAE = Hailo-8, M.2 module A+E key 2230 - industrial

- Temperature Range: -40 to +85°C

- HM218B1C2KAE/HAI

- HS Code: 85176200

- Country of Origin: Taiwan

- Pack size for bulk orders: 20 (you can order one piece on this page; please contact us for bulk requests)

- Lead Time: currently 12 weeks.

Sicherheitsangaben

- Lesen Sie die Bedienungsanleitung sorgfältig durch, bevor Sie das Produkt verwenden.

- Stellen Sie sicher, dass alle Montage- und Installationsanweisungen des Herstellers sorgfältig befolgt werden.

- Verwenden Sie das Produkt nur für den vorgesehenen Zweck.

- Die unsachgemäße Nutzung dieses Produkts kann zu schweren Verletzungen oder Sachschäden führen.

- Nicht für Kinder unter 10 Jahren geeignet.

- Bei unsachgemäßer Verwendung besteht eine Verletzungsgefahr.

- Dieses Produkt entspricht den geltenden Sicherheitsanforderungen der Europäischen Union.

- Dieses Produkt wurde gemäß der GPSR geprüft, die sicherstellt, dass alle relevanten Sicherheitsanforderungen für Konsumgüter eingehalten werden.

Nachverfolgbarkeitsinformationen

Jedes Produkt verfügt über eines oder mehrere der folgenden Merkmale:

- Ein CE-Kennzeichen, das die Einhaltung der Sicherheits-, Gesundheits- und Umweltschutzanforderungen der Europäischen Union anzeigt.

- Eine eindeutige Serien- oder Chargennummer, um die Nachverfolgbarkeit zu gewährleisten und bei Bedarf Rückrufaktionen zu unterstützen.

- Hersteller- und Importeurangaben für den Kundensupport und Sicherheitsanfragen.

Überwachung und Berichterstattung von Vorfällen

Für den unwahrscheinlichen Fall eines Produktproblems haben wir Verfahren implementiert, um:

- Kundenbeschwerden zeitnah bearbeiten.

- Schwerwiegende Vorfälle über das EU Safety Gate/RAPEX-System melden.

- Mit den Marktüberwachungsbehörden zusammenarbeiten, um die öffentliche Sicherheit zu gewährleisten.

Kontakt:

- Email: support [@] pi3g.com

- Telefon: 0341 / 392 858 40

Dieses Produkt ist vollständig mit allen geltenden EU-Vorschriften konform, um die Sicherheit unserer geschätzten Kunden zu gewährleisten.